LED通信事業プロジェクト エンジニアブログ

【社内雑談】 AppleとOpenAIの提携について

記事更新日 2024年6月18日

はじめに

今回はいつもと違った趣向で、社内の雑談を記事にしてお送りしたいと思います。話題は、AppleとOpenAIの提携について。あまり通信とは関係無い話題ですが、通信のエンジニアとして長年活動しているメンバー同士の雑談を公開してみました。役に立つか、立たないかは分かりませんが、ものの見方の一つとして捉えて頂ければと思います。

尚、何度も書いていますが、このブログは個人の見解で、会社としての方針では決してありません。個人が勝手に書いているものだとしてお読みください。(尚、この雑談にあたっては、Google Geminiを活用しています。)

Apple Intelligenceについて

社員A(以下A): 今年のWWDC※1でAppleが「Apple Intelligence」を発表しました。これはAppleによるAIですが、なんと言っても最大のポイントはOpenAIのChatGPTとの提携でした。前々から噂はされていましたけど、Microsoftの資本ががっちり入っているOpenAIと本当に提携するんだと驚きました。AppleはOpenAIと組んでどういうことがしたいんでしょうか?

社員B(以下B): 発表によると、iOS等AppleのOSからChatGPTが直接呼び出せるということで、これまでユーザーによる検索の一部がChatGPTに代わる、となってるね。

A: Apple IntelligenceとはChatGPTの事なんですか?それとも、Apple IntelligenceとChatGPTは違うものなんですか?

B: いろいろなニュースを読む限り違うものらしい。Apple Intelligence自体は、ローカル端末、つまりiPhoneやiPad上で動くAIを総称しているみたい。ChatGPTとかのLLM※2は、大量の学習データをベースにクラウド上で動くのが一般的だけど、Apple Intelligenceはスマホやノートブック上のみで完結するAI、つまりローカルで動くAIのようだ。Googleでいうところの、Android用AIのGemini Nanoに該当すると思う。ちなみに、LLMに対して小さいモデルだからSmall Language ModelでSLMと呼ぶ人もいるけど、Googleはそう呼んでいないし、定義も曖昧なので、ここではそういった呼び方はしないね。

A: なるほど。それにしても、Apple IntelligenceとChatGPTは全然違うものなんですね。勘違いしている人は多いんじゃないですか?

B: うん。ニュースの見出しだけ見ると、Apple IntelligenceがChatGPTだと勘違いしてしまう可能性は高い。

Apple Intelligenceはオフラインのローカル端末上で動くため、負荷というか計算量が大量に必要となる。そのため、実はiPhoneだとiPhone 15 Pro以上でしか動かない。iPhone 15 Proは最新機種の、しかも上位機種だから、現状は極めて一部の機種のみ対応ってことで、現実は市場にあるほとんどのiPhone上では動かないと言って良い。しかも、それだけ機種を限定しても、それでも負荷が大きいらしくて、電池とか発熱とかの状況によってはクラウドに投げることもあるそうな。

A: へー、そうなんですか。ローカルAIとはいえ、結構巨大なAIなんですね。

B: Gemini Nanoも、最新の一つ前のPixel 7以上対応だから、軽量版とはいえ、生成AIを動かすのは相当なCPUパワーが必要なんだろうね。Googleの話だと、次期Gemini Nanoは、クラウドで動く最初期のGemini1.0と比べて80%ぐらいの性能は出せる※3とのことなので、そう考えると計算量は凄いんだと思う。

A: そこで疑問なのは、じゃあAppleはApple Intelligenceがあるのに、なぜChatGPT搭載となったのか?ということなんです。一応、チャット型のAIであるSiriは、Apple Intelligenceで動くんですよね?

B: Siriでは対応できないリクエストが来たときに、それで初めてChatGPTに投げるってことらしいよ。

A: そうなんですか。何か理解できないですね。

B: 結局、今のAppleだと完全なLLM型AIは準備できないってことだと思う。Apple Intelligenceにできること、できないことは現時点で発表されていないけど、Gemini Nanoのできること、できないことと比較してみると、Apple Intelligenceの方もおおよそ予想が付く。

Gemini Nanoがインターネット接続しないで

| できること | できないこと |

|---|---|

| 決まった言語の翻訳 音声認識 文章の要約 単純な質問への応答 |

不特定多数の言語の翻訳 テキストの生成 プログラミングコードの生成 複雑な質問、最新の質問への応答 |

Apple IntelligenceのSiriが担当することは、これまでのSiriを考えると、上の表の最下段、太字にした部分だと思うんだよね。そして、SiriであるApple Intelligenceも、同じローカルAIのGemini Nanoができない「複雑な質問、最新の質問への応答」みたいなことはできないはず。また、Androidだと、Gemini Nanoができないことは、ブラウザでも動く、私も普段から使っている普通のGemini(Pro)が処理している。そう考えると、SiriがApple Intelligenceでできない「複雑な質問、最新の質問への応答」を、ChatGPTが担うのではないかと思われる。

A: なるほど。Gemini Nanoと比較すると、予想しやすいですね。

B: GoogleはGeminiがフルLLMによる生成AIだから、Gemini Nanoの上にGemini Pro、さらにAdvancedとあって、Nanoができないことは上位バージョンが担当すれば良いだけだけど、AppleはApple Intelligenceという軽量のAIしか持っていないため、フルLLMのサポートが必要な部分はChatGPTに投げたんだろうと思うよ。

A: 我々にとっても、難しい質問に答えてくれたりして、初めて生成AIって感じがしますものね。ローカルAIのSiriだけじゃ、ちょっと物足りないですよね。

B: Androidのアシスタントは、すでに生成AIであるGeminiに入れ替わっているから、ローカルSiriだけじゃ勝負が厳しいんじゃないかな。最近のAIの進化は凄いけど、それは巨大クラウドによる計算量があってこそ。端末の計算量とデータだけじゃ、そこまで生成AIの恩恵は受けられないから。もちろん、Googleの消しゴムマジックとかは凄いけど、それが生成AIの実力か?と言われるとね。

株価が上がったApple

A: さて、このApple IntelligenceとChatGPT連携の発表によって、発表時は株価が一時下がりましたが、その後急上昇したようです。どうやら、iPhoneに買い換えが促進される可能性があるということで株価が上がっているという報道ですが。Bさんは、どう思いますか?

B: うーん。なぜこんなにAppleの株価が上がったのか、私には分からないんだよね。Apple IntelligenceがiPhoneの売上に大きく寄与することにも正直懐疑的。前述の通りローカルAIには限界があると思っているし、ChatGPT搭載だけで画期的に代わるなら、MS OfficeのCopilotが世の中変えているはず。そして、ChatGPTを使いこなしている人は、既にOS関係無く使いこなしているし。

そう考えると、私はAppleとChatGPTとの連携は「AppleはフルLLMが構築できなかった」という事実があらわになっただけじゃないか、という気がしないでもない。

A: でも、AppleはiPodやiPhone、Apple Watchのように、既存の製品の再発明的な事が得意であり、それがAIでも再現されるのではないか、と見ている専門家も多いようで、そういった論調の記事も沢山ありましたよ?

B: それはそうなんだけど・・・ 挙げて貰った例、iPodもiPhoneもApple Watchも、すべてハードウエアの再発明なんだよね。むしろ、ソフトウエア側については、Appleは常に最新、最先端であり、むしろ真似されてきたのがAppleだと思うんだ。歴史あるMac OSは常にマイクロソフトの先を行っていたし、iPodとiTunesの連携とか、以前記事にもしたけどiPhone登場時のiOSの革新的なUIとか。

A: 確かに、Appleはソフトウエアに関しては、先端を行って追っかけられる方ですね、言われてみれば。

B: LLMはソフトウエアではあるけど、一般的な”容易にコピーできるソフトウエア”ではなく、大規模なハードウエアありきなものだから、これまでのソフトウエア、という扱いで考えるべきではないかもしれない。だから、今見えている情報ではGoogleの後追いっぽい状態だけど、近い将来にAppleが生成AIを再発明できる可能性は十分にあるとは思う。

A: そうですね。Appleですしね。

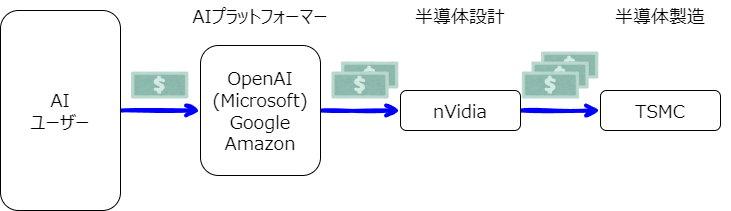

B: ただ、その場合でもLLMを外注となると、Appleに利益が生まれるのか?という心配がある。下の図はTwitterで著名なゆな先生が以前出していた図を(直接使うわけにはいかないので)アレンジしたものなんだけど、生成AI業界におけるお金の流れってこの図の様になるんだよね。

A: そうか、生成AIを遡っていくと、TSMC※4とnVidiaにたどり着くのか。そしてその二社が儲かるようになっているのか?nVidiaなんて、ただの謎の半導体メーカーのはずなのに。

B: nVidiaの儲けっぷりと、株価の上がりっぷりが凄いからか、今週の読売KoDoMo新聞という小学生向け新聞にnVidiaの特集記事があったほど。つまり、小学生へ紹介すべき話題になるほど注目されているんだよね。まあ、ゲームオタクでグラボ命のAくんは昔からnVidiaのお世話になっていただろうけど、一般人の知名度はまだ低いから記事になるんだけどね。

それで、なぜnVidiaなのかってことだけど、現在の生成AIの計算には大量のGPUが必要で、現状GPUなんてnVidiaとAMDしか作ってない。それで、nVidiaは、以前よりGPUコンピューティング※5を推進していて、このGPUコンピューティングがAIとバッチリはまった。だから、生成AI以前のディープラーニングAIの頃から、AI関連はnVidiaのほぼ独占状態だった。現在は、nVidiaのGPUチップ以上にCUDAというnVidiaのプログラミング用プラットフォームから乗り換えるのが難しいようだ。ハードウエア性能的にはAMDでも置き換えられるけど、CUDA(と周辺ツール)が置き換えられない。

A: なるほど。ハードとソフトセットでnVidiaだから、AIはnVidia独占状態なんですね。

B: 話が脱線しちゃった。Appleの話に戻るけど、OpenAIやGoogleは、nVidiaほどではないが、一応商流の上流にいるわけ。Googleに関しては、加えて自前のチップでAI回すようになってきているけど、それも含めて上流だ。一方、Appleの今の動きは、残念ながら生成AIの世界では1ユーザーでしかない。

しかも、LLMをぶん回すためのクラウドも、AIで先行するMicrosoft※6、Google、Amazonと比べ、かなり弱い※7。つまり、AIのためのインフラでも負けている。

A: 仮に生成AIがはまったとしても、Appleは生成AIでマネタイズする力が弱いのか・・・ 確かに、今回の発表でもiPhone等の端末の売上以外でAIをマネタイズする方法は提示されていないですね。

B: AppleはiPhoneという高い市場占有率を持つ末端機器を握っているから、現在は強い立場でAIプラットフォーマーと交渉できるけど、もし、GoogleかMicrosoftが生成AIを利用した画期的ななにかをPCやスマートフォンに搭載したとき、iPhoneの優位性は一気に崩れるんじゃないか、という恐れがあるんだよね。そして、画期的な何かで世の中をガラッと変えてしまう可能性が生成AIにはあると思うんだよね。

そして、仮にその画期的何かをApple自身が発見したとしても、それがローカルAIでできるレベルのもので無い限り、Appleは大して儲からない。iPhoneが一時期ちょっと売れる程度で、すぐにGoogleに真似されて、追従されちゃう。

A: そう見ると、現在のAppleも安泰って訳じゃないのか。生成AIが当たり前になればなるほど、今のままじゃAppleは苦しくなると。

B: そう思っている投資家が結構いて、WWDC直後は株価が落ちたんだと思う。その後、買い換え要素でiPhoneが売れるんじゃないかという期待で株価が上がった。でも、よく考えると、前者は長期的視点に立っての判断で、後者は短期的視点に立っての判断だよね。それを混同してはいけないと思う。

ARMの話

A: それじゃあ、結局生成AIで儲かるのは、TSMCとnVidiaだけってことか。

B: 長くなるからTSMCとnVidiaの話は今度別の機会に。ただ、Appleが関わる部分としては、nVidiaの分野とは違うところで、ちょっと新たな動きが起ころうとしているね。

A: なんですか?。

B: この間、Microsoftが、今年5月に新しいPCの発表をした。新しいPCというより、AI時代のPCの基準を発表したと言った方が正しいか。ポイントは、そのAI PCの性能条件。メモリとストレージについての条件もあったのだけど、一番影響が大きかったのは、CPUに関する条件。その条件は

- 40TOPS以上の性能を持つ、ニューラル処理ユニット(NPU)を持つプロセッサ、SoCを搭載すること

というものだったんだ。

A: CPUに詳しくない人には分かりにくいですね。まず、40TOPSというのが分かりませんし、NPUも分かりません。これらは何を意味するんですか?

B: まず、NPUだけど、Neural Processing Unitの略。つまり、AI計算用のプロセッサのこと。nVidiaのGPUに似ているけど、よりAIに特化したもの。有名なのは、Google Pixelに搭載のTensorだね。GoogleはTPU(Tensor Processing Unit)って名乗ってるけど。

次にTOPS。Tはテラ。10の12乗ね。OPSはOperations Per Secondの略。一秒間の計算回数。通常、浮動小数点演算の回数であるFLOPSという単位がプロセッサの性能を表すんだけど、AIに浮動小数点演算は不要だから、ここがただのOPSになったんだと思われる。

まとめると一秒間に40テラ回計算できるAIチップを搭載したPCが、Microsoftの「AI PC」を名乗れるってことだね。

A: なるほど。で、これがなんで影響が大きいんですか?

B: このMicrosoftのAI PC、ブランド名を「Copilot + PC」としたんだけど、5月にお披露目した際、Microsoft自身も含めた複数メーカーからCopilot + PCが発表されたんだ。ASUS、Dell、HP、Lenovoとかね。それで、その全てのPCが、QualcommのSoCであるSnapdragon搭載だったんだ。

A: え?QualcommのSnapdragonって、スマホ向けのSoCですよね?

B: 「主に」という点ではそうだね。このSnapdragonはPC向けのハイエンドSoCだからスマホ向けとは違うけど、ARMベースという点は同じだよ。

A: Windows PCの発表なのに、全てARMベースのSoCなんですか?

B: どうやら、Intelの40TOPS対応NPUが間に合わなかったみたいなんだ。だから、「最初のCopilot + PCはすべてARMベースになった」とニュースになっていた。ARMって、以前は「省電力だけど低性能」ってことで、スマホとかそういった機器に使われていたけど、この件はもはや性能でもARMがx64を上回る※8ってことを表しているんだよね。

A: そうか。そういえば、今のAppleのMacも、M1 Macbook以降ARMベースになっていますけど、そこでもIntel CPUに劣るという話は出ていませんね。もはやARMが遅いというのは過去の話なんですね。となると、WindowsとMACは、今後ARMでの戦いになるってことですか?

B: もちろん、IntelもAMDもこのままってことはないし、そのうちx64 Copilot + PCが発表されると思うけど、もしかしたら、消費電力や価格の問題などでNPUとしてはARMベースの方がよいってことになる可能性はある。となると、クラウドのLLMとは異なる「ローカルAIの戦い」がARMベースで展開されていく。というか、すでにスマホとMacはARMなわけだし、ライブラリ次第でそうなる可能性の方が高い。特に、ビジネスノートブック(のCopilot + PC)とかは、ARMが一般的になってしまうかも。

A: いやー、それはIntelにとって恐ろしい未来ですね。

B: それ以外にも、GoogleはAIサーバー用のARMベースチップを自前で製造することを発表している。もともと自社のPixel向けSoCを自前で作っていて、それをサーバー用にしたものだね。さっきも言ったけど、GoogleはNPUをTPUと呼んでいてるけど、GoogleはAI用TPUを、サーバー側もクライアント側も全てARMベースにするようだ。まあ、Googleは、ライブラリとかツールとかのソフトウエア側も全部自前で作れちゃうから、例外(な会社)かもしれないけど。

A: 例外かもしれないけど、Googleは全部ARMにするんですね。そう考えると、何年か前にnVidiaは(ソフトバンクから)ARMの買収に失敗しましたけど、今になってnVidiaは悔しがっているかも知れませんね。

B: だろうね。ARMも抑えられれば、AI半導体を全て抑えたことになったはずだからね。当時、ソフトバンク孫会長は、本心かどうかは別として「ARMのCPUとnVidiaのGPUは全く違うもので、何故独禁法に抵触するのかわからない」みたいなことを言っていたけど、この件においては買収を阻止したイギリス政府の方が先見の明があったということかな。

A: まさか、イギリス政府がそこまで予測していたとは思えないけど・・・

B: とにかく、ローカルAIで、Appleが勝つのか、Microsoftが勝つのか、Googleが勝つのか、それは分からないけど、生成AIが広がるとARMが儲かる、というのは間違いないと思う。

まとめ

A: というわけで、AppleとOpenAIの提携って話から、いろいろな話をしましたが、そろそろまとめて頂けますか?

B: 現状を見ると、クラウドの(真の)LLMにしても、そのサブセットであるローカルAIにしても、プロセッシングパワーがもっともっと必要であるってこと。より頭の良い生成AIのためには、AIサーバーをどんどん立てていかないといけないし、スマホやPCはこれまで以上に高性能にならなければAIが動かない。Appleも、Microsoftも、Googleも、結局はこれにつきると思う。

A: そうですね。計算力、処理能力こそが生成AIであり、LLMですもんね。

B: となると、やっぱり最終的にはTSMCが儲かるって事にしかならないな・・・

A: 結局、そこに落ち着くんですか。

B: そこは、仕方ない。

それと、一応最後、無理矢理通信と生成AI絡めるとしたら、生成AIにとって通信はボトルネックではないので、今以上の通信性能は要らないってことかな?

A: それじゃ、我々儲からないじゃないですか!

B: ChatGPTとかGeminiとか使っている人なら分かるけど、通信の遅延なんてちゃんちゃらおかしいほど、生成AIは遅いんだよね。それは、クラウド側の処理能力が足りないからだけど、処理能力を上げるには、散々説明した通り、金も時間もかかるし、そもそもnVidiaのGPUが足りない。したがって、当面はここままだと思う。だから、現状では簡単な処理は極力クライアント側で処理させる必要があって、Apple IntelligenceやGoogle Gemini Nanoみたいなローカル小型生成AIも活用しなければいけない。クラウド以前の「サーバーとクライアントの話」が生成AIで復活している感じだ。歴史は繰り返す。

それで、なるべくローカル機器、つまりクライアントサイドで処理するなら、通信もさほど使わない、になるよね。5GNRが言っているような「低遅延がAIに必要になる世界」なんて5Gが主力の間には来ないと思う。これは、AIどうこうとか通信どうこうではなく、半導体の進化とお金の話だからね。AIにミリ秒以下の遅延が必要となるのは、6G、下手すりゃ7Gまで待たなきゃいけないかもしれない。そんなとこかな。

A: なんか、通信業界には夢も希望も無い話で終わりましたね。

B: AIだけが通信コンテンツじゃないんで。他のことで頑張りましょう(笑)。

以上

※1; Worldwide Developers Conference、日本語で世界開発者会議。毎年6月にAppleが開催するイベントで、Apple関係のソフトウエア開発者、技術者が参加できる。基調講演では、新製品、ソフトウエア等が発表される(事が多い)。

※2; Large Language Model、日本語で大規模言語モデル。本件の話題となっている生成AIは、基本的にLLMで構築されている。

※3; https://wired.jp/article/google-io-gemini-on-android-circle-to-search/

※4; Taiwan Semiconductor Manufacturing Company、日本語では、台湾セミコンダクター・マニュファクチャリング・カンパニー。世界最大の半導体委託工場(ファウンダリ)であり、世界最先端の工場を持つ。TSMCにしか作れない高集積化半導体も多く、nVidiaだけでなく、Apple、Google、AMD、Qualcomm等世界の名だたるメーカーがTSMCに半導体製造を委託している。

※5; 一般的に、グラフィック以外の計算はCPU(インテル等が作っている汎用チップ)で行うが、その一部をGPUに任せようとする技術。GPUは汎用性は低いが、特定の計算においては非常に高速のため、用途が合った場合は、CPUよりも圧倒的に高速に計算ができる。

※6; Microsoftは、ChatGPTを開発するOpenAI社の最大のスポンサーであるため、OpenAI社への大きな影響力を持つ。

※7; 令和5年度版情報通信白書

※8; 64ビットインテル互換のCPUのことを、通称x64と呼ぶ。(尚、x64の仕様を作成したのはAMD)